算力困局:

AI竞赛的“不可能三角”

在DeepSeek突围之前,AI领域普遍存在一种固化的技术认知,即大模型性能与算力投入呈严格正相关。这一观点几乎成了业界的共识。美国人工智能初创公司Anthropic首席执行官达里奥·阿莫迪曾透露,GPT-4o的模型训练成本约为1亿美元。OpenAI为了训练GPT-4,使用了数万块英伟达A100GPU,而微软则为其提供了名为“星际之门(Starship)”的超级计算机集群支持。同时,谷歌也投入了其庞大的TPU(Tensor Processing Unit)资源来训练诸如PaLM 2等模型。这些行业巨头通过巨额的投入,不断强化“算力即权力”的行业法则。

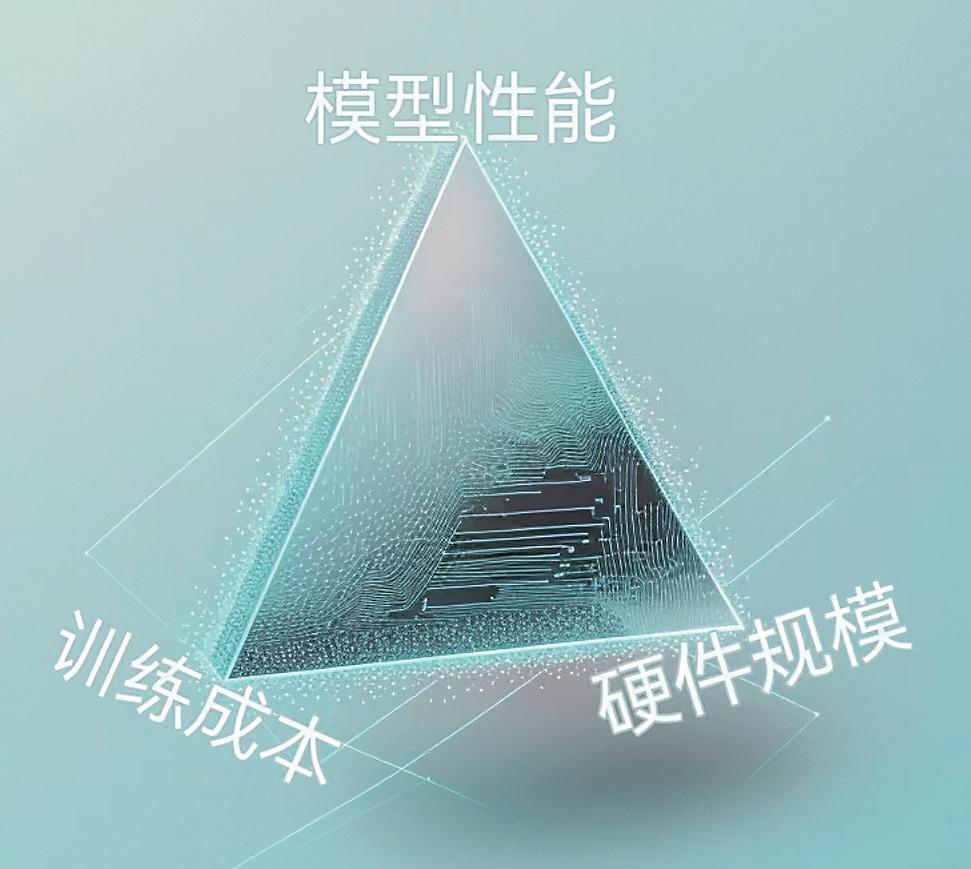

这种算力霸权形成了严酷的“不可能三角”困境——模型性能、训练成本、硬件规模这三者难以兼得。面对这一困境,许多初创公司要么选择轻量化模型牺牲性能,要么在沉重的算力开支重压下艰难前行,最终耗尽资金。

令人欣喜的是,DeepSeek打破了这一僵局。数据显示,Deep-Seek-V3模型训练成本仅为557.6万美元,而且仅用2048块H800显卡,耗时不到两个月。这一成就无疑是对传统算力霸权的一次有力挑战。DeepSeek-V3发布后,360集团创始人周鸿祎发文称赞“Deep-Seek的进步对推动中国AI产业发展是极大利好”,其用2000块卡做到了万卡集群才能做到的事。

架构革命:

DeepSeek重构AI底层逻辑

DeepSeek的技术路径展现了对AI研发底层逻辑的颠覆性理解。其核心突破不在于单纯压缩模型规模,而是通过架构创新重构了“算力—性能”的价值函数。

在长文本方面,DeepSeek-V3引入了一种称为多头潜在注意力的机制。这种机制将Key(K)和Value(V)联合映射到低维潜空间,从而有效地减小了KV Cache的大小,提高了模型处理长文本的能力。在资源调度方面,通过采用混合专家模型(MoE)架构,Deep-Seek-V3能够根据输入动态选择最合适的神经网络路径进行计算,而不是每次都激活整个网络。这种方法可以在不显著增加计算成本的前提下扩展模型容量,并且只在需要时使用更多的计算资源。

为了进一步提升MoE架构的效率,DeepSeek-V3设计了一个动态调整的偏置项(Bias Term),它影响路由决策,避免了传统负载均衡策略带来的性能损失。它通过调节更新速度(γ)和序列级平衡损失因子(α)来优化模型训练。

在内存优化方面,Deep-Seek-V3采用了新兴的低精度训练方法——FP8混合精度训练。使用低精度浮点数(如FP8格式)进行计算可以减少内存占用和计算需求,同时保持较高的准确性。这意味着DeepSeek-V3能够在相同的硬件上运行更大规模的模型或在更少的硬件上完成相同的任务。

简单来说,模型压缩、专家并行训练、FP8混合精度训练、推测性解码等一系列创新共同促成了Deep-Seek-V3模型的低成本和高性能。

打破桎梏:

算力不应成为认知革命的绊脚石

斯坦福HAI《2024年人工智能指数报告》指出,AI模型在医疗、材料科学等领域的应用增速是基础研究的3倍以上。站在技术演进的时间轴上回望,DeepSeek的突破在AI领域堪称重大里程碑。此前,算力效率一直是限制AI发展的瓶颈,而如今,随着这一桎梏被打破,创新能量开始呈指数级释放。

DeepSeek的火爆出圈揭示了一个更深层的技术哲学:当行业沉迷于堆砌算力的“暴力美学”时,真正的突破往往来自对计算本质的重新理解。就像量子力学颠覆经典物理的认知框架,这场架构革命证明,智能的进化不完全依赖物理算力的线性增长,而在于发现更“优雅”的算法表达。

或许在不远的未来,我们会看到更多轻量化、小而美的AI模型,在边缘设备、在移动终端、在每个人的口袋里,持续释放着超越物理限制的认知潜能。这场始于算力逻辑重构的技术革命,最终指向的是对人类智能边界的重新丈量。

关键词:

凡注有"环球传媒网"或电头为"环球传媒网"的稿件,均为环球传媒网独家版权所有,未经许可不得转载或镜像;授权转载必须注明来源为"环球传媒网",并保留"环球传媒网"的电头。